2.3.1 配置 Standalone 模式

步骤1: 复制 spark, 并命名为spark-standalone

cp -r spark-2.1.1-bin-hadoop2.7 spark-standalone

步骤2: 进入配置文件目录conf, 配置spark-evn.sh

cd conf/

cp spark-env.sh.template spark-env.sh

在spark-env.sh文件中配置如下内容:

SPARK_MASTER_HOST=hadoop201

SPARK_MASTER_PORT=7077 # 默认端口就是7077, 可以省略不配

步骤3: 修改 slaves 文件, 添加 worker 节点

cp slaves.template slaves

在slaves文件中配置如下内容:

hadoop201

hadoop202

hadoop203

步骤4: 分发spark-standalone

步骤5: 启动 Spark 集群

sbin/start-all.sh

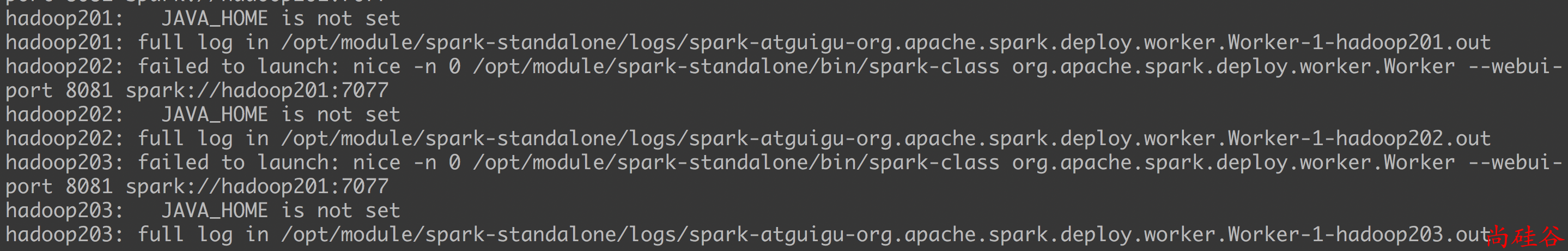

可能碰到的问题

- 如果启动的时候报:

JAVA_HOME is not set, 则在sbin/spark-config.sh中添加入JAVA_HOME变量即可. 不要忘记分发修改的文件

步骤6: 在网页中查看 Spark 集群情况