2.3.4 配置 Spark 任务历史服务器(为 Standalone 模式配置)

在 Spark-shell 没有退出之前, 我们是可以看到正在执行的任务的日志情况:http://hadoop201:4040. 但是退出 Spark-shell 之后, 执行的所有任务记录全部丢失.

所以需要配置任务的历史服务器, 方便在任何需要的时候去查看日志.

步骤1: 配置spark-default.conf文件, 开启 Log

cp spark-defaults.conf.template spark-defaults.conf

在spark-defaults.conf文件中, 添加如下内容:

spark.master spark://hadoop201:7077

spark.eventLog.enabled true

spark.eventLog.dir hdfs://hadoop201:9000/spark-job-log

注意:

步骤2: 修改spark-env.sh文件,添加如下配置.

export SPARK_HISTORY_OPTS="-Dspark.history.ui.port=18080 -Dspark.history.retainedApplications=30 -Dspark.history.fs.logDirectory=hdfs://hadoop201:9000/spark-job-log"

步骤3: 分发配置文件

步骤4: 启动历史服务

需要先启动 HDFS

sbin/start-history-server.sh

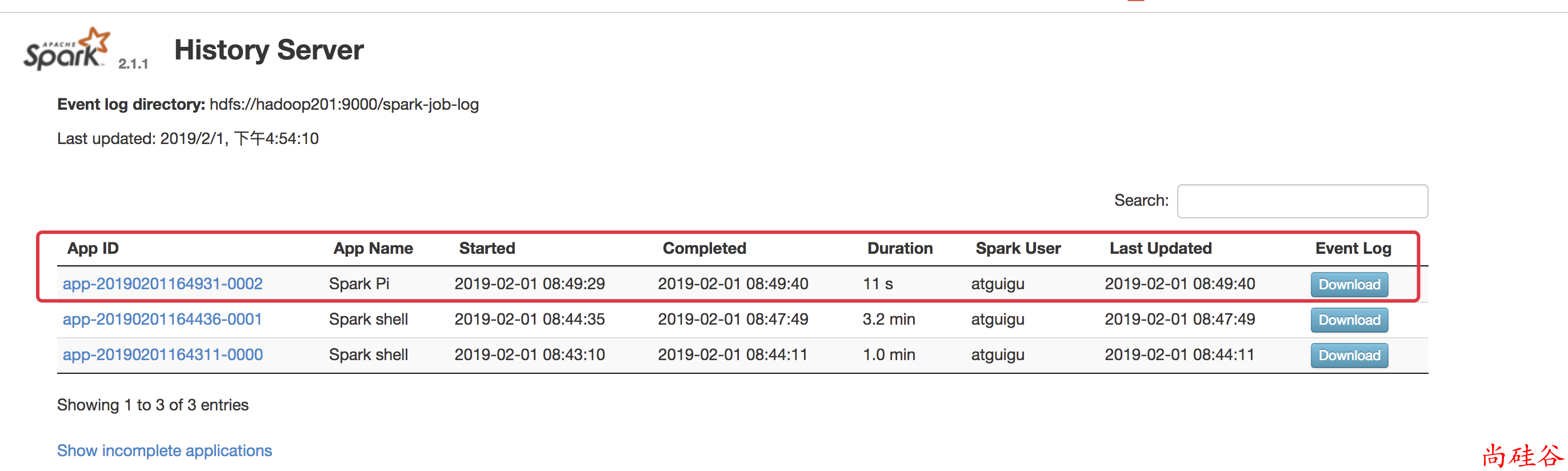

ui 地址: http://hadoop201:18080

步骤5: 启动任务, 查看历史服务器

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://hadoop201:7077 \

--executor-memory 1G \

--total-executor-cores 6 \

./examples/jars/spark-examples_2.11-2.1.1.jar 100